如何批量提取小红书博主所有笔记链接?在进行内容创作或者市场调研时,获取真实、有效的素材是至关重要的,尤其是在互联网时代,社交平台的内容成为了信息流动的主要渠道。对于很多创作者而言,小红书作为一个热门的社交电商平台,聚集了大量的博主和用户,其笔记内容涉及的领域非常广泛,从时尚、美妆到旅行、健康、育儿等,每一篇笔记都可能成为启发灵感的源泉。然而,想要从小红书获取所需素材并不容易。平台上内容的数量庞大,信息更新速度快,博主的笔记之间往往没有直接的链接,手动逐个查找、提取这些笔记链接显然不现实。如果只是从单一博主的页面收集资料,也许还算简单,但当需要批量获取多个博主的所有笔记链接时,这项工作变得繁重且复杂。这时候我们就可以借助下面的方法进行链接的批量提取,如果你对这项技能感兴趣,就请点赞支持一下吧。

方法一:使用电脑软件提取

软件推荐:星优链接复制器

推荐指数:☆☆☆☆☆

系统兼容:目前这个软件只能支持Windows10及以上系统

软件下载:https://www.xingyousoft.com/softcenter/XYLinks

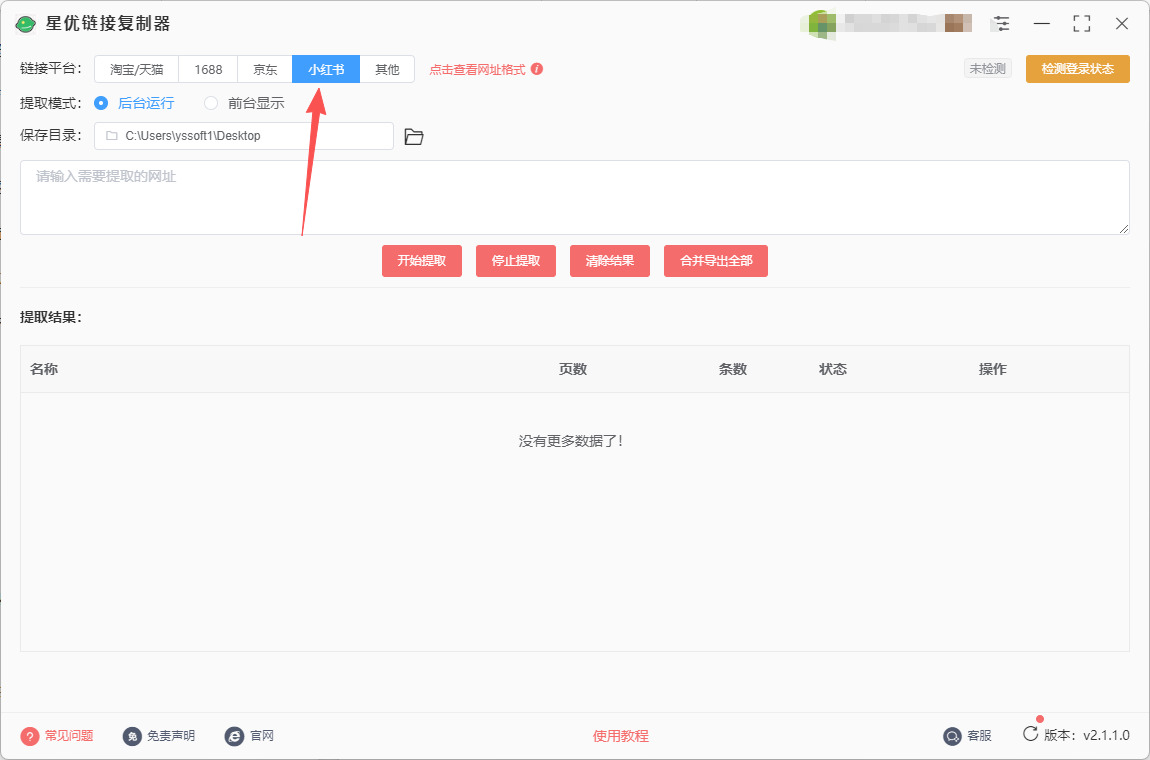

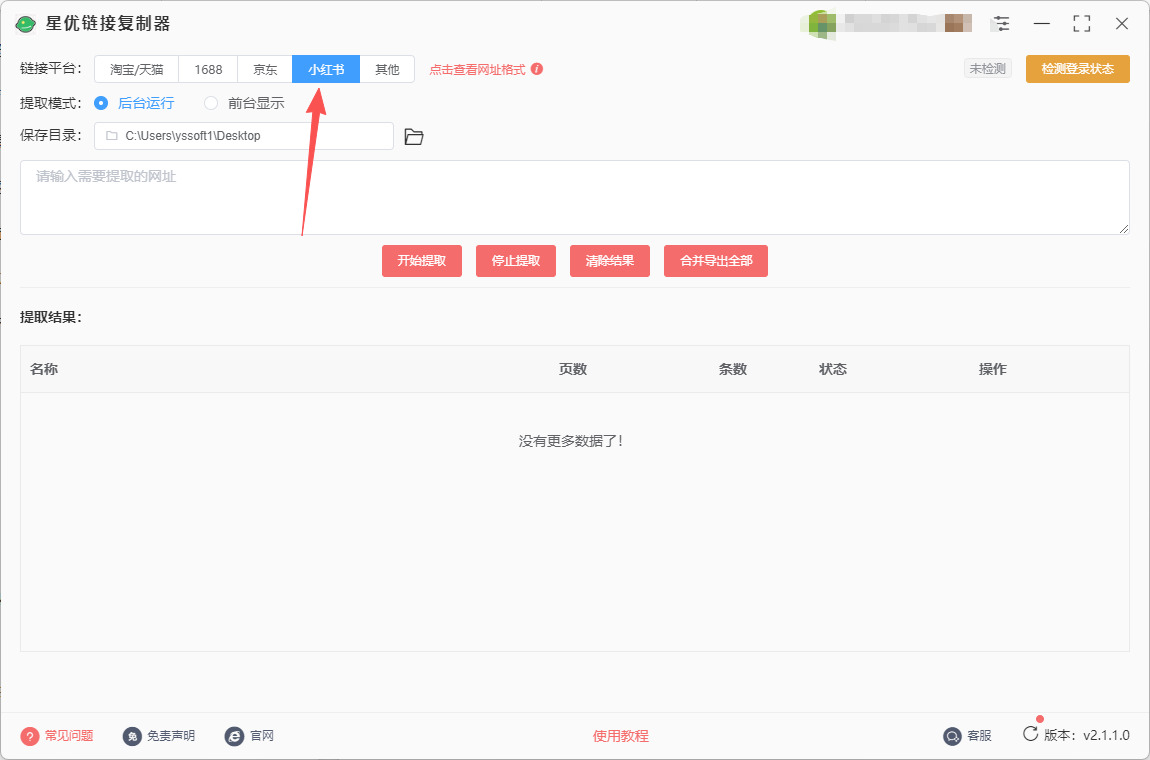

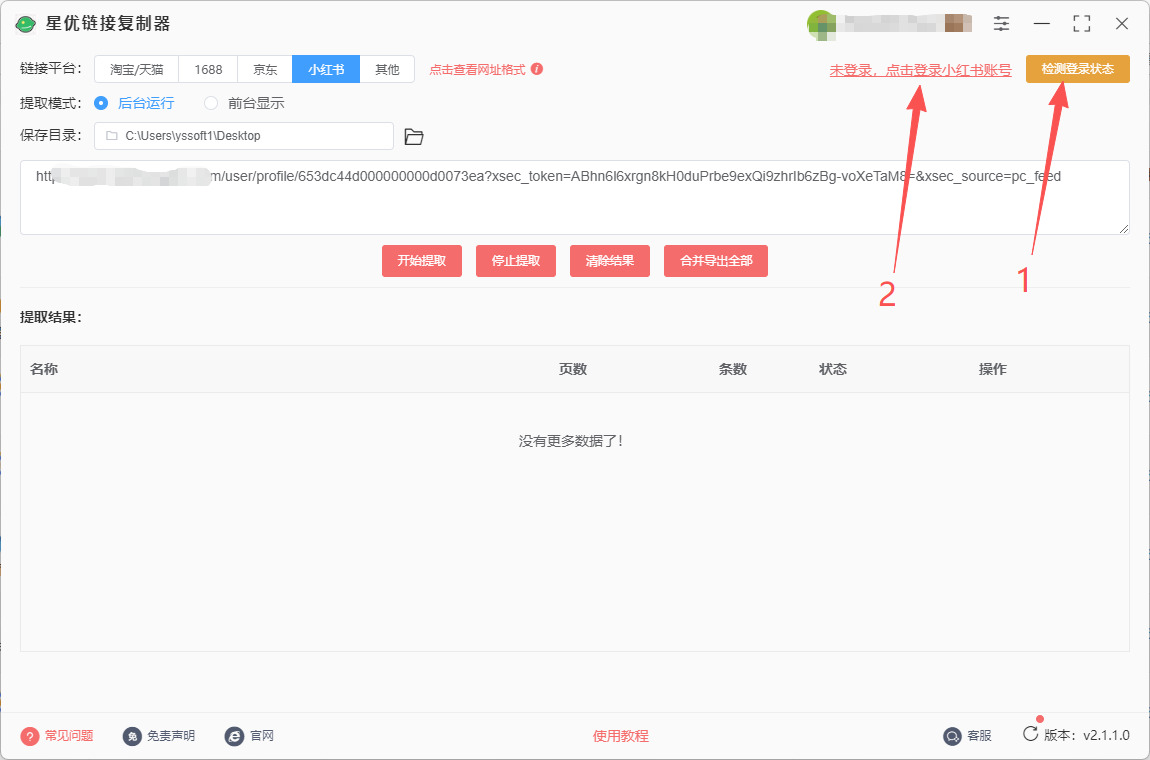

第1步,打开软件并选择功能

请将本方法中推荐的星优链接复制器软件安装好,安装好之后打开使用,你需要在上方的【链接平台】右侧选择“小红书”。

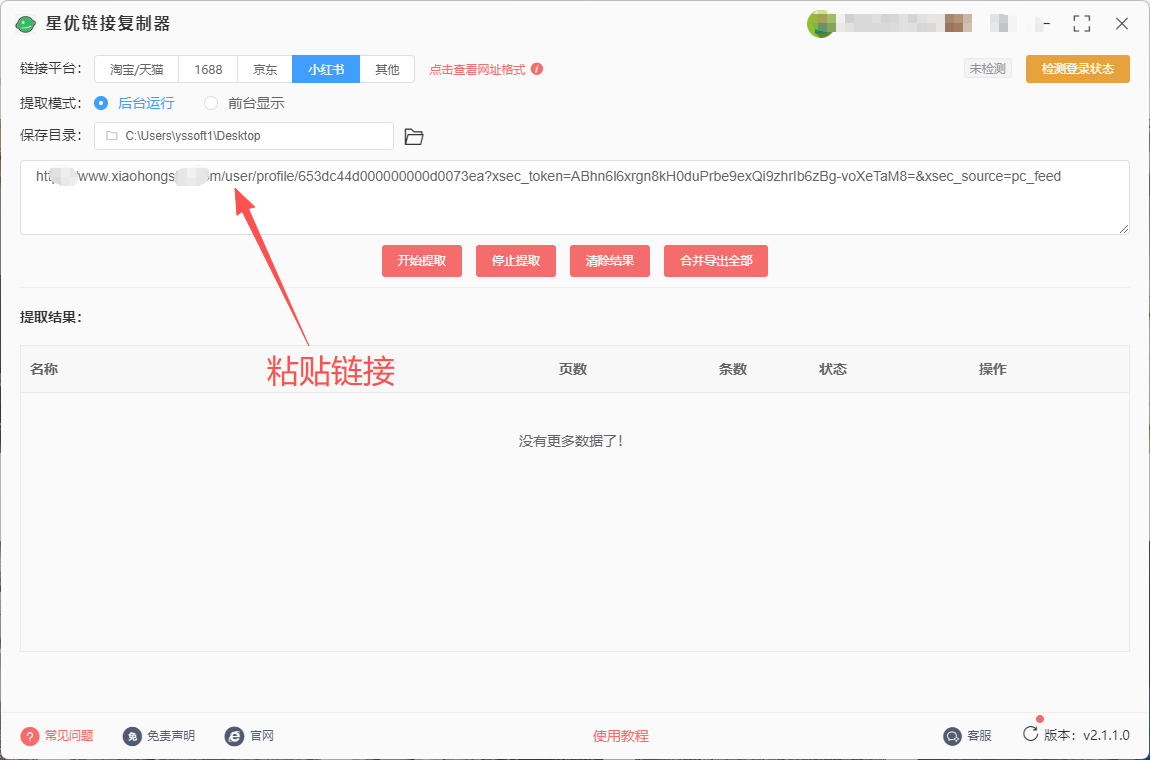

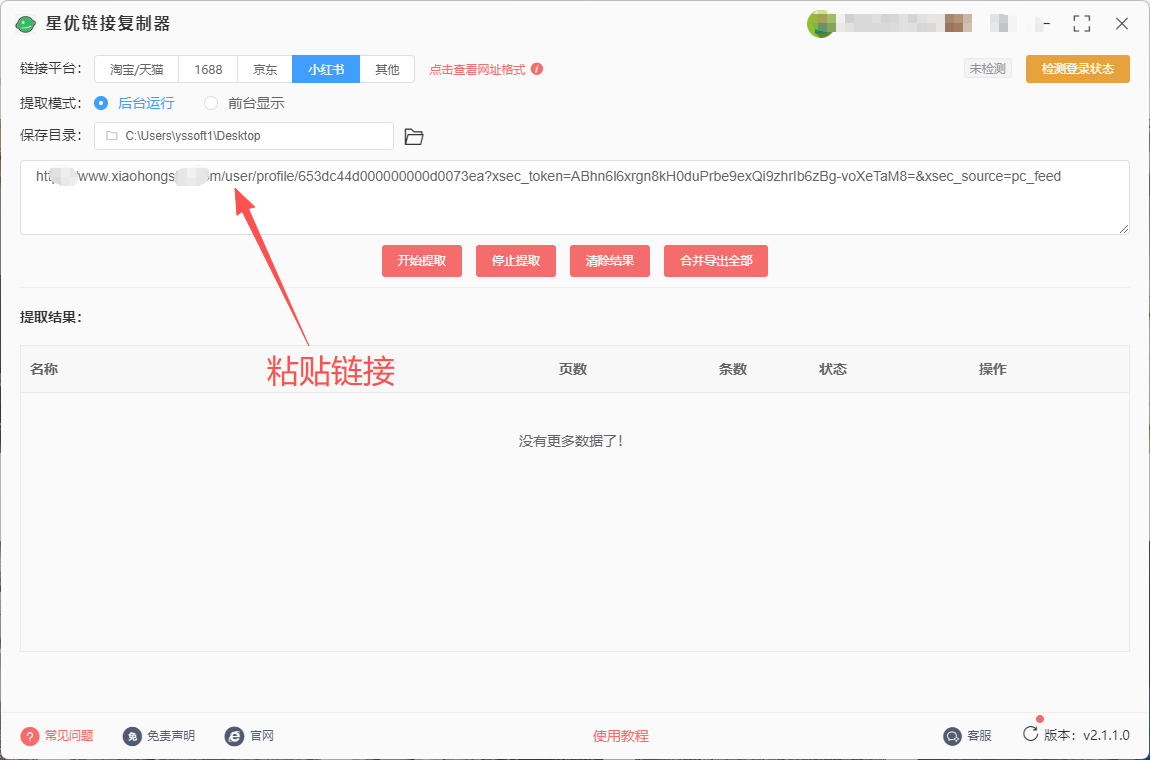

第2步,复制链接并添加到软件

① 请通过浏览器打开小红书,随后找到里面博主的主页,随后将主页网址链接复制下来。

② 软件里面有一个输入框,请将复制的链接粘贴到这个输入框里。

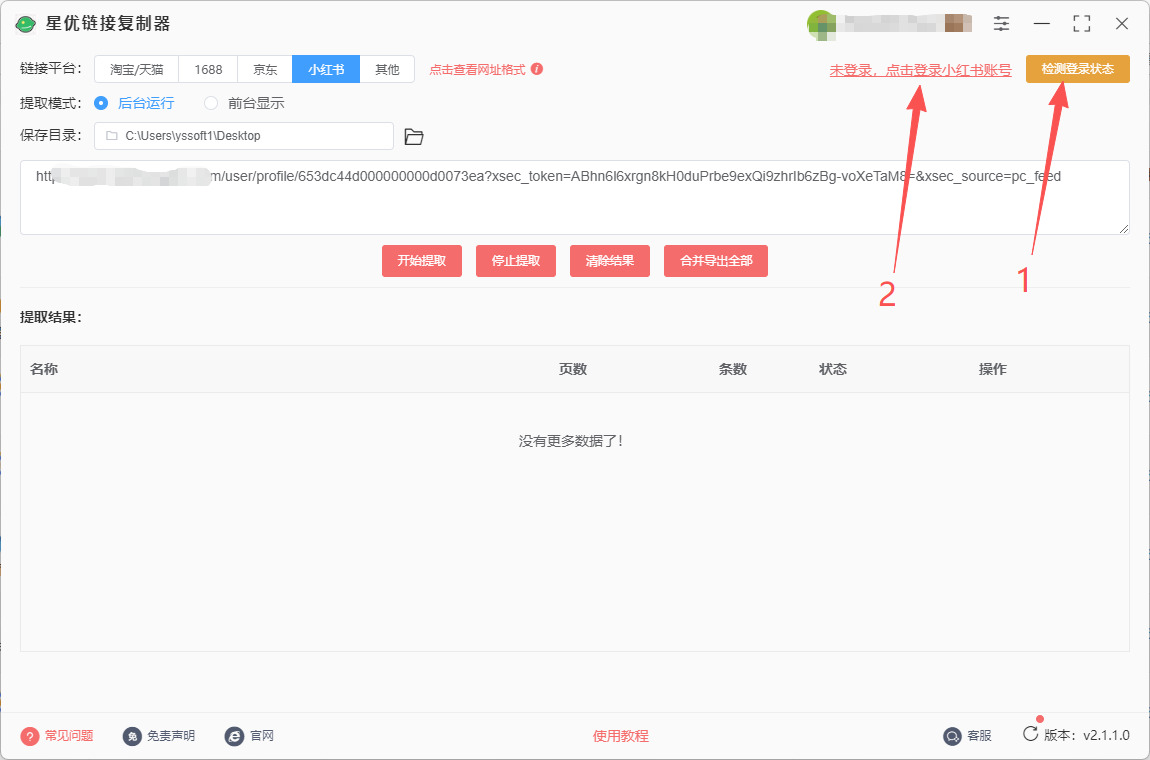

第3步,登录小红书账号

① 先点击右上角“检测登录状态”按键,随后旁边会弹出“未登录,点击登录小红书账号”文字按键,点击此文字按键。

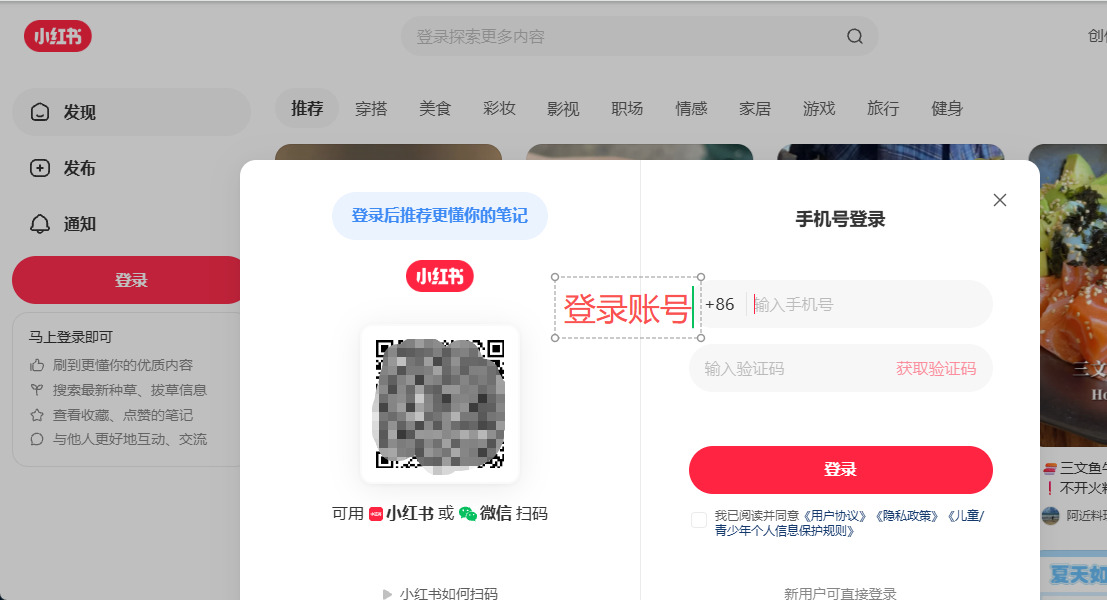

② 这时候软件会立即弹出小红色登录窗口,请使用验证码方式进行登录,登录结束后需要关闭登录窗口。

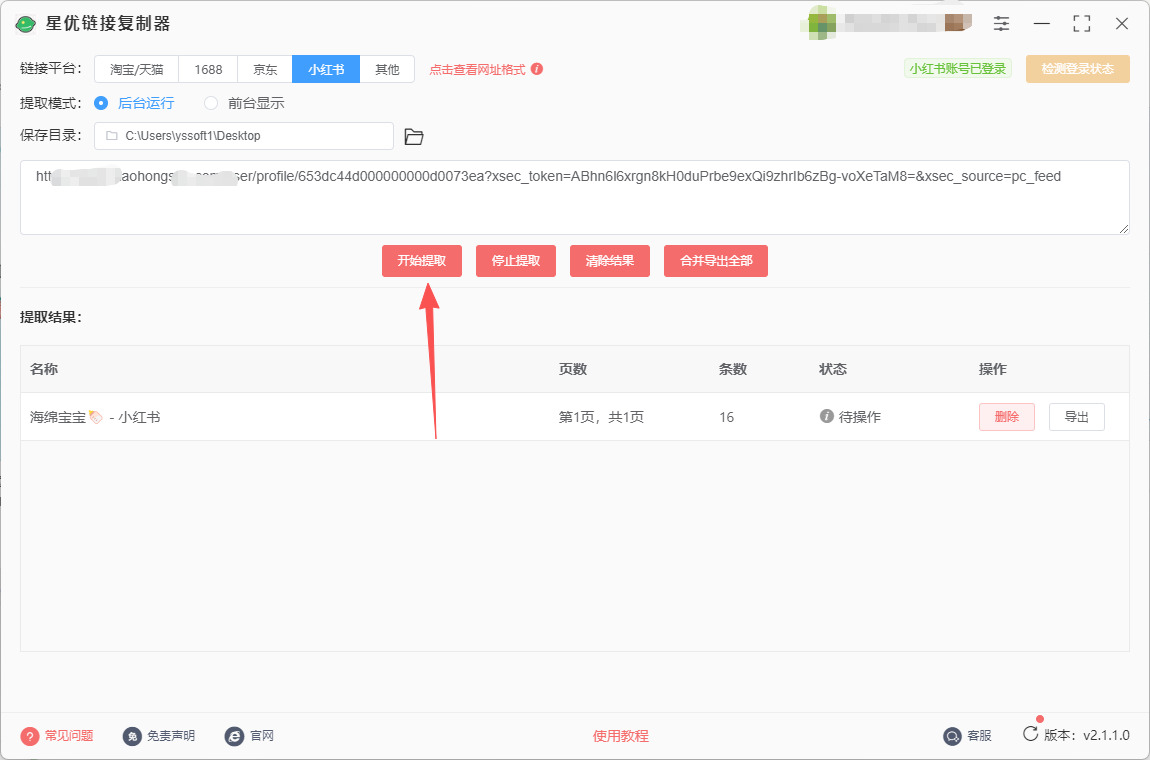

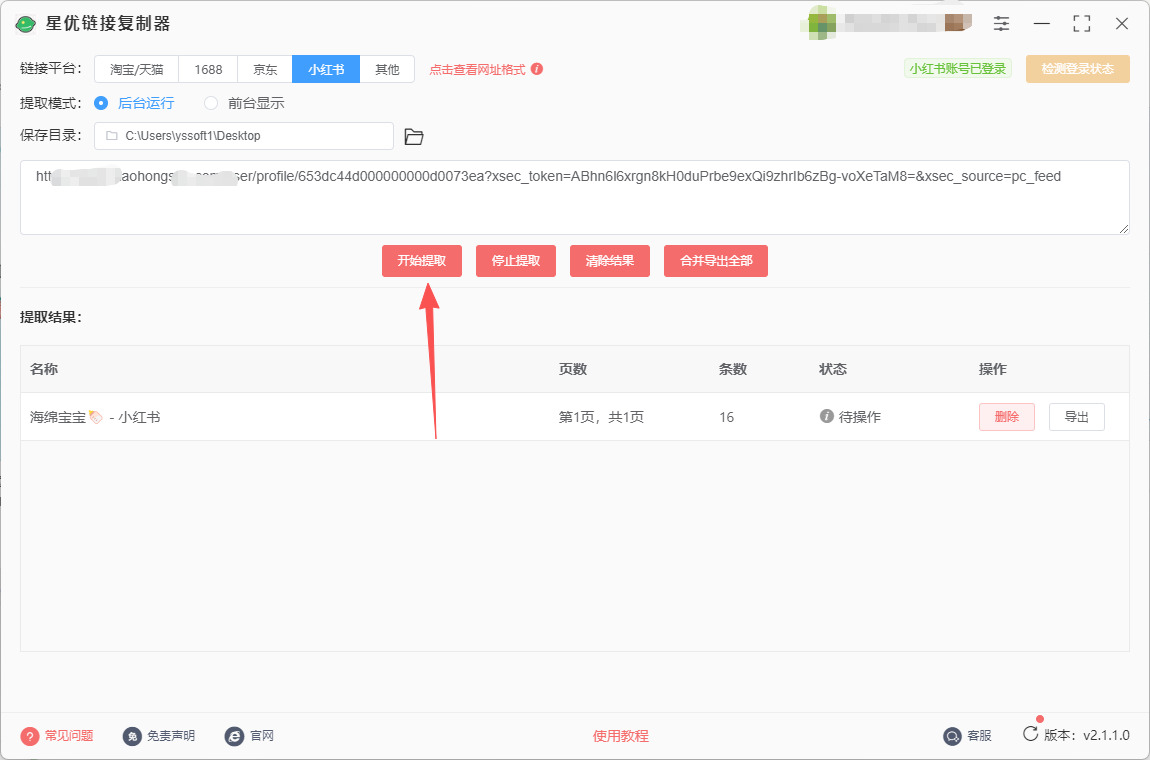

第4步,启动提取程序

随后点击【开始提取】按键,软件立即启动链接提取程序,链接越多提取时间越久,并且在软件下载可以看到提取的详细信息(如链接数量等)。

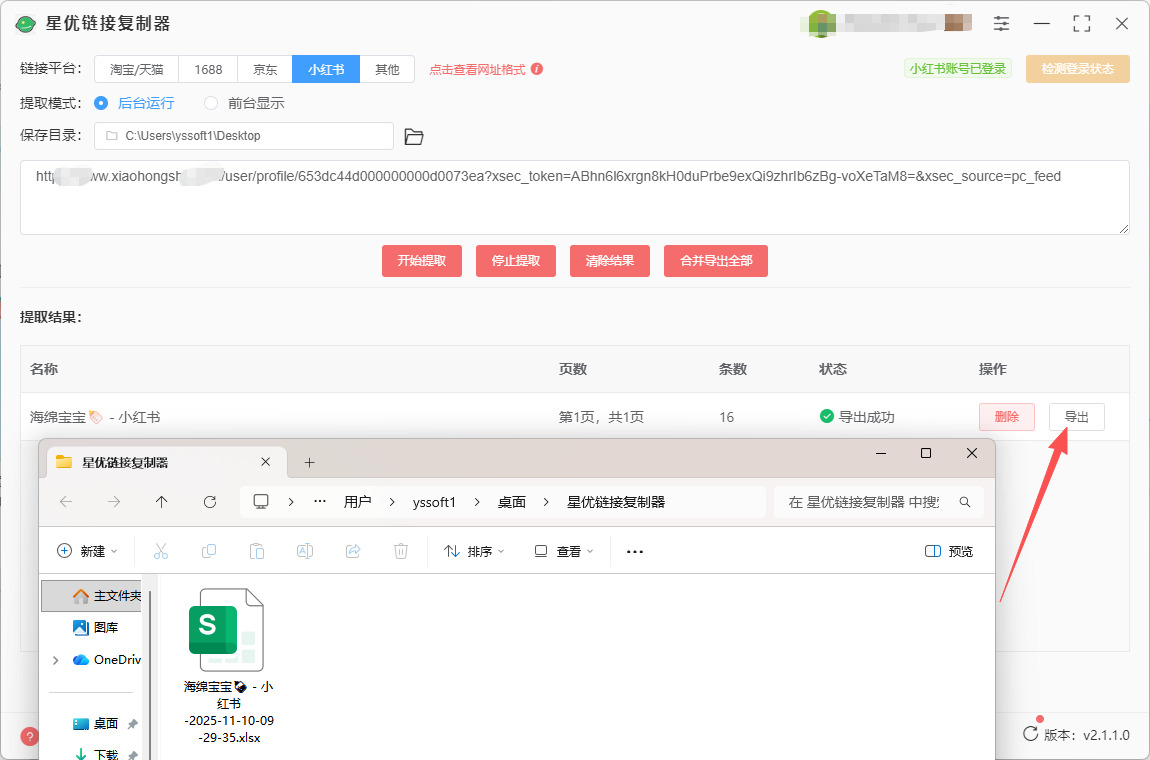

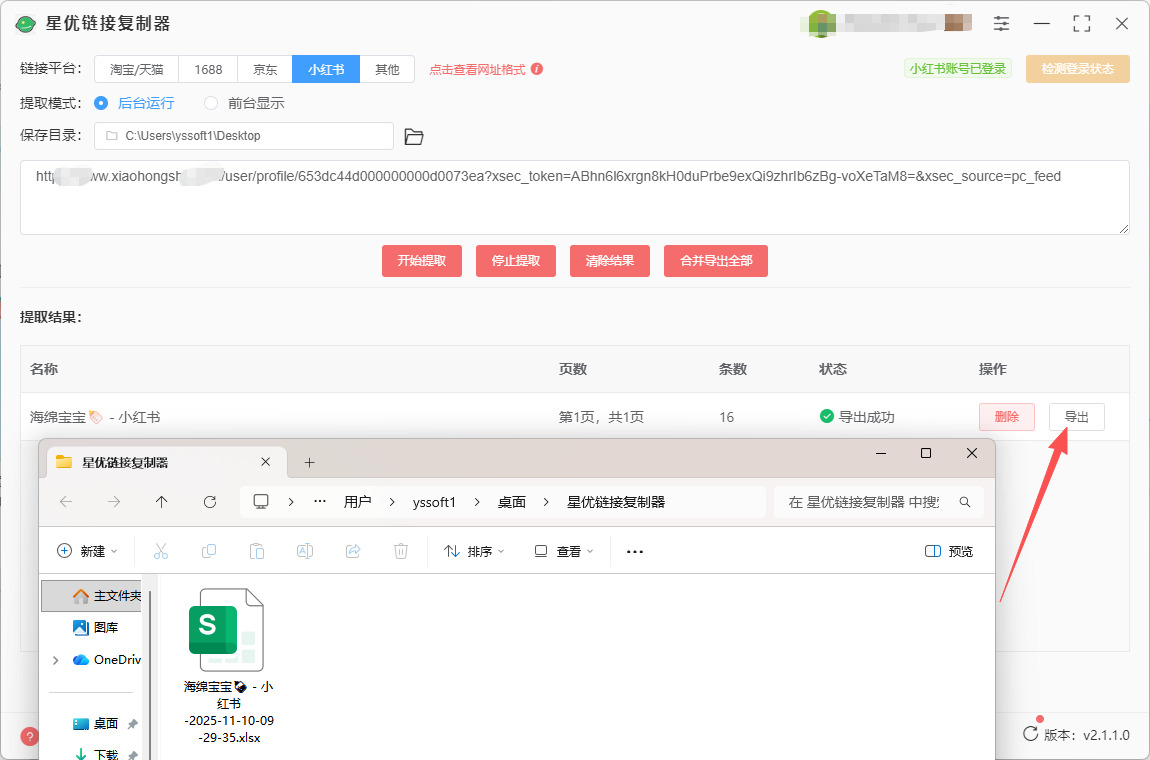

第5步,导出链接

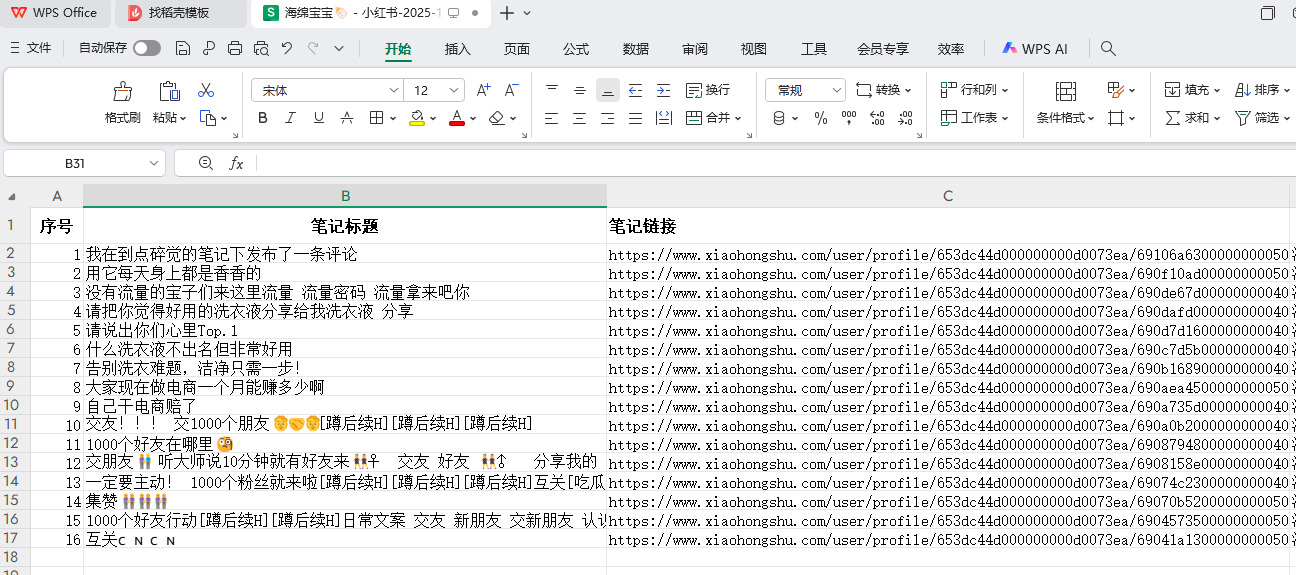

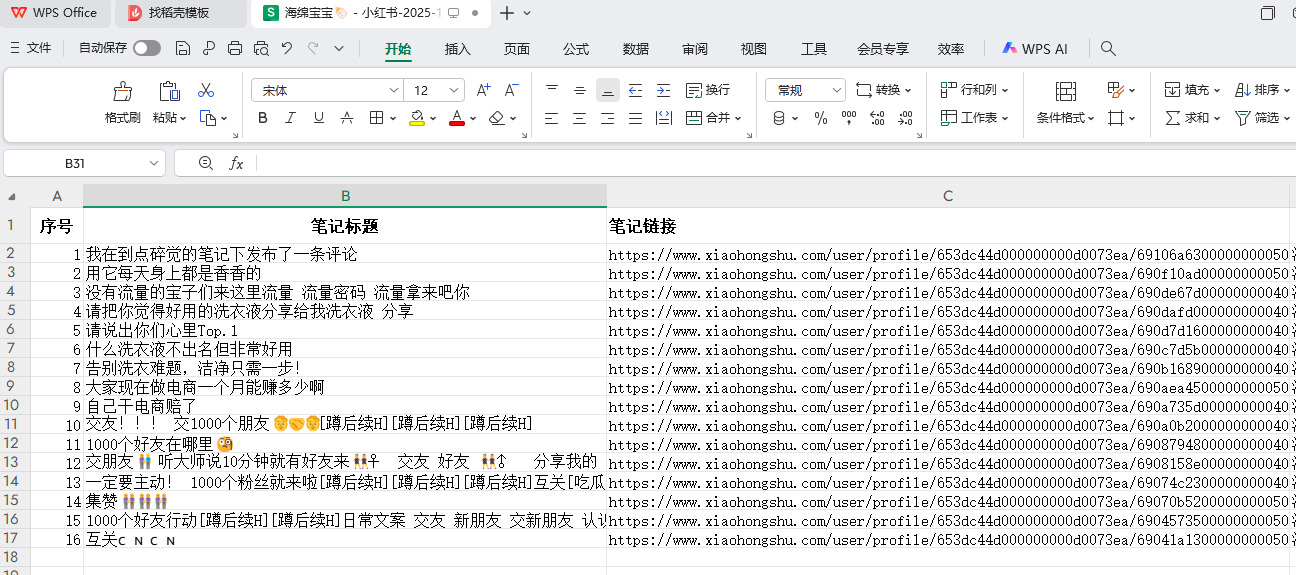

① 如下图所示点击【导出】红色按键就可以将提取的链接全部导出来,导出格式为excel表格。

② 打开导出的excel表格进行检查,可以看到所有链接被成功提取,还包含了笔记名称,发布时间,阅读量等信息。

方法二:使用链接提取工具

软件工具:Red-Downloader

推荐指数:☆☆☆☆

推荐理由:支持提取博主发布、收藏、点赞、专辑的作品链接,以及推荐页、搜索结果中的笔记链接。

系统支持:支持Windows 10+、Mac OS

步骤1、获取博主主页链接

打开小红书网页版,找到目标博主的主页,然后复制主页链接。

步骤2、使用Red-Downloader提取链接

方式1:程序运行(推荐新手)

① 获取并解压Red-Downloader(支持Windows/macOS/Linux)。

② 双击运行 main.exe(Windows)或 ./main(macOS/Linux)。

③ 在程序界面选择 “链接提取” 功能。

④ 粘贴博主主页链接,设置输出文件路径(如 links.txt)。

⑤ 启用 “自动去重” 和 “格式清洗” 选项,点击 “开始提取”。

⑥ 程序会自动滚动加载博主所有笔记,并提取链接到文件。

方式2:命令行模式(适合进阶用户)

bash

python main.py "xxxxxx/user/profile/xxxxxx" --extract-links

提取的链接会保存到默认文件(如 output/links.txt)。

步骤3、验证结果

打开生成的 links.txt 文件,检查是否包含所有笔记链接(格式为:xxxxxx/discovery/item/xxxxxx)。

方法三:使用Python程序

1. 准备环境

首先,我们需要一些必要的工具库来完成爬虫操作。常用的库包括 requests、BeautifulSoup 和 pandas,用于发送请求、解析 HTML 和存储数据。

pip install requests beautifulsoup4 pandas

2. 获取博主主页的 URL

首先,需要获取博主的主页 URL,通常格式是 xxxxxxx/user/profile/{user_id},user_id 是博主的唯一标识符。你可以通过访问小红书的个人主页,获取每个博主的主页 URL。

3. 设置请求头

因为小红书是一个有反爬虫机制的站点,我们需要伪装成浏览器来发送请求。通过设置 User-Agent 来模仿真实的浏览器。

python

import requests

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36' }

4. 请求博主主页并获取数据

使用 requests 库来发送 GET 请求获取博主主页的 HTML 页面,然后用 BeautifulSoup 来解析页面。

python

from bs4 import BeautifulSoup

def fetch_blogger_profile(user_id):

url = f'xxxxxxx/user/profile/{user_id}'

response = requests.get(url, headers=headers)

if response.status_code == 200:

return response.text

else:

print("请求失败", response.status_code)

return None

# 示例,替换为实际博主的 user_id

user_id = '12345678' # 替换为目标博主的实际 ID

html_content = fetch_blogger_profile(user_id)

5. 解析博主笔记链接

在博主的主页中,所有的笔记链接通常会嵌套在特定的 HTML 标签中(例如 <a> 标签),所以我们需要使用 BeautifulSoup 来提取这些链接。

python

def extract_note_links(html_content):

soup = BeautifulSoup(html_content, 'html.parser')

# 根据实际的 HTML 结构来提取笔记链接

links = []

for a_tag in soup.find_all('a', {'class': 'note-link-class'}): # 你需要分析页面,查找笔记链接所在的实际标签

link = a_tag.get('href')

if link:

links.append(f"URL")

return links

# 提取链接

if html_content:

note_links = extract_note_links(html_content)

for link in note_links:

print(link)

注意:小红书的具体 HTML 结构可能会随时间更新,因此你需要根据页面的实际结构来调整 find_all 中的选择器(例如 {'class': 'note-link-class'})。

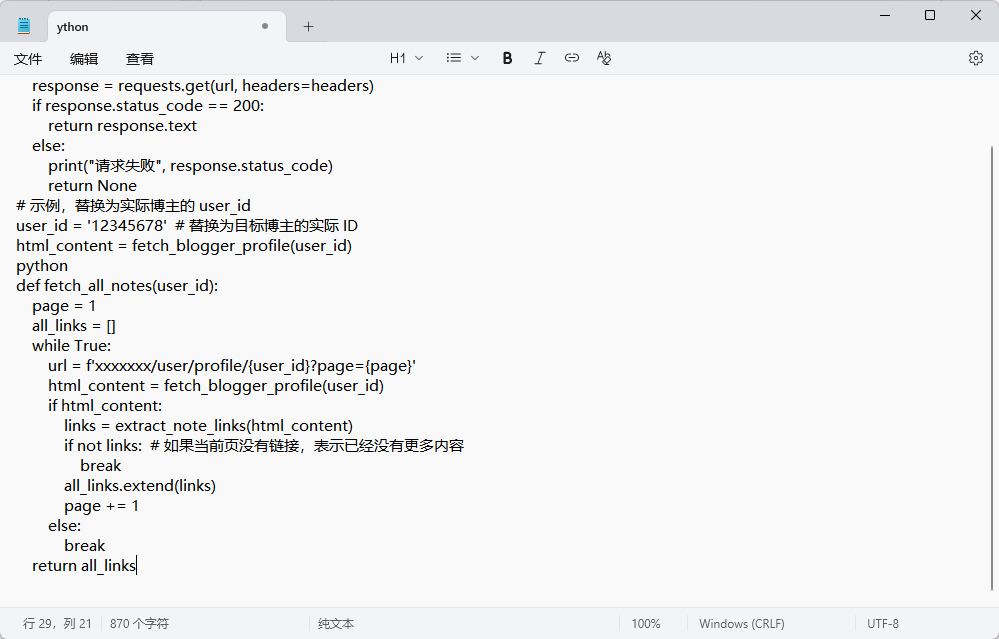

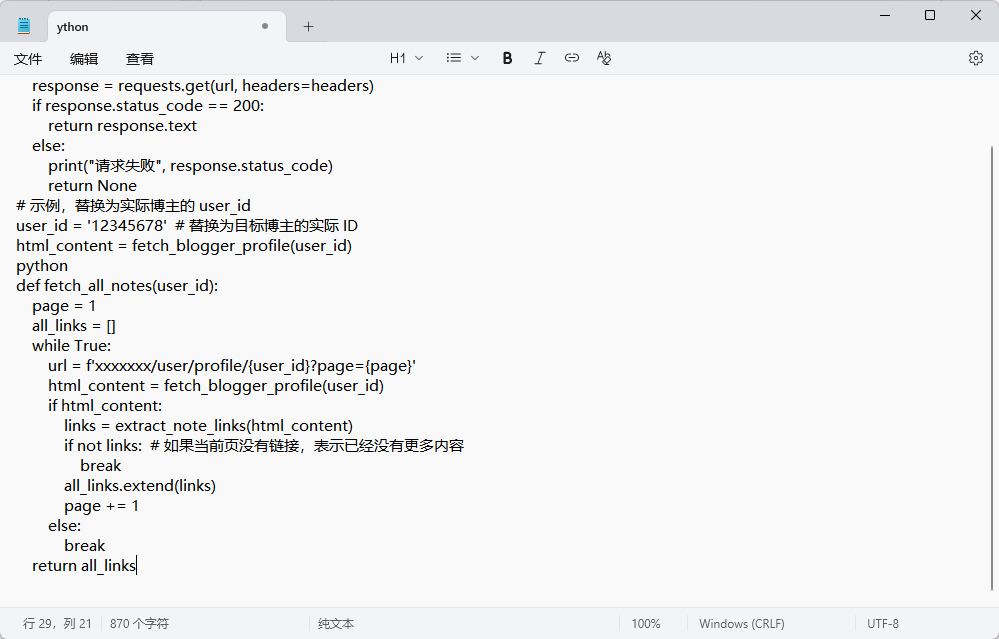

6. 分页加载更多笔记

通常,小红书的主页会有分页功能,笔记数据可能是按页加载的。你需要遍历多个分页,直到提取所有笔记链接。分页的实现通常通过 URL 参数(如 page)来实现。

python

def fetch_all_notes(user_id):

page = 1

all_links = []

while True:

url = f'xxxxxxx/user/profile/{user_id}?page={page}'

html_content = fetch_blogger_profile(user_id)

if html_content:

links = extract_note_links(html_content)

if not links: # 如果当前页没有链接,表示已经没有更多内容

break

all_links.extend(links)

page += 1

else:

break

return all_links

# 获取所有笔记链接

all_note_links = fetch_all_notes(user_id)

for link in all_note_links:

print(link)

7. 存储提取的数据

提取到的笔记链接可以保存到一个 CSV 文件中,方便后续使用或分析。

python

import pandas as pd

def save_links_to_csv(links, filename='note_links.csv'):

df = pd.DataFrame(links, columns=['Note Links'])

df.to_csv(filename, index=False)

# 保存链接到 CSV 文件

save_links_to_csv(all_note_links)

8. 进一步优化

并发请求:如果数据量很大,可以通过使用 asyncio 和 aiohttp 库来进行异步请求,提高爬取速度。

数据去重:在存储之前,考虑去重,以避免存储重复的笔记链接。

每一位小红书博主的笔记内容都有其独特的价值,有的笔记可能包含了最新的产品测评,有的则可能提供了极具创意的生活技巧。想要获取这些信息,往往需要在浩如烟海的笔记中迅速筛选并保存相关链接,以便后续分析、整理和使用。无论是想要提炼出某一领域的趋势,还是想要根据博主的内容创作自己的推广策略,获取小红书博主所有笔记的链接成为了必不可少的一步。但批量提取笔记链接并非一项简单的任务。这不仅仅是为了搜集链接,更重要的是在海量的内容中快速定位出与自己需求高度契合的素材。这些素材可以为创作提供灵感,为市场分析提供依据,甚至可以帮助品牌方精准定位目标用户群体,从而制定更具针对性的营销方案。因此,如何高效地批量获取小红书博主的所有笔记链接,成了许多内容创作者和市场分析人员亟需解决的问题。这不仅能大幅提高工作效率,还能在激烈的竞争中获得更多独特的内容资源,为下一步的创作和策略制定打下坚实的基础。方法已经分享给大家了,最重要的是大家亲手操作,这样才能更快的学会哦。